É fascinante ver como a IA evolui, aproximando-se cada vez mais da inteligência humana. Essa jornada começou com Alan Turing e seu teste em 1950, mas ganhou forma oficial em 1955, quando John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon propuseram o Dartmouth Summer Research Project on Artificial Intelligence – o berço do termo “Inteligência Artificial”.

Como os LLMs Impulsionaram (e Limitam) a Evolução da IA

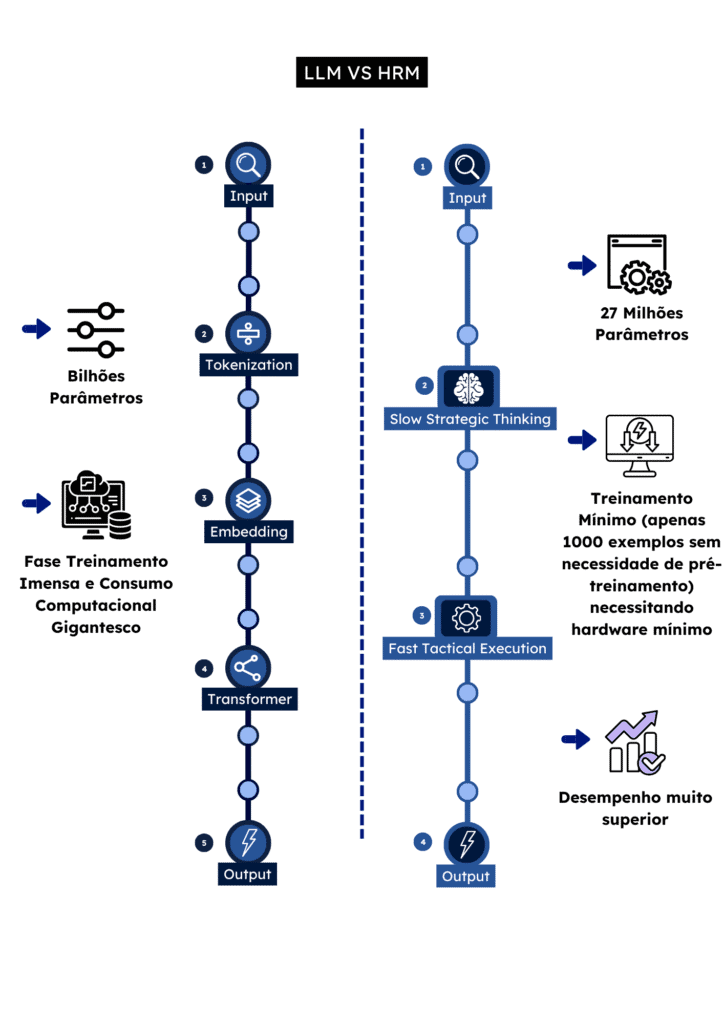

Os LLMs, baseados em redes neurais profundas, revolucionaram a IA com resultados impressionantes. No entanto, eles operam de forma “artificial”: preveem palavras sequencialmente a partir de treinamentos massivos, o que traz limitações como fragilidade em decomposições de tarefas complexas, alto consumo de dados e latência elevada.

O Cérebro Humano: Um Modelo Muito Além de Probabilidades

Por mais improvável que possa ser o minuto seguinte em nossas vidas não decidimos os nossos passos baseados em chutes ou probabilidades, não funcionamos 100% do tempo tentando adivinhar o que precisamos ter respostas, obvio que não, pois não é assim que nosso cérebro funciona. Então como ele funciona?

A Dinâmica Natural do Cérebro

Cross Frequency Coupling

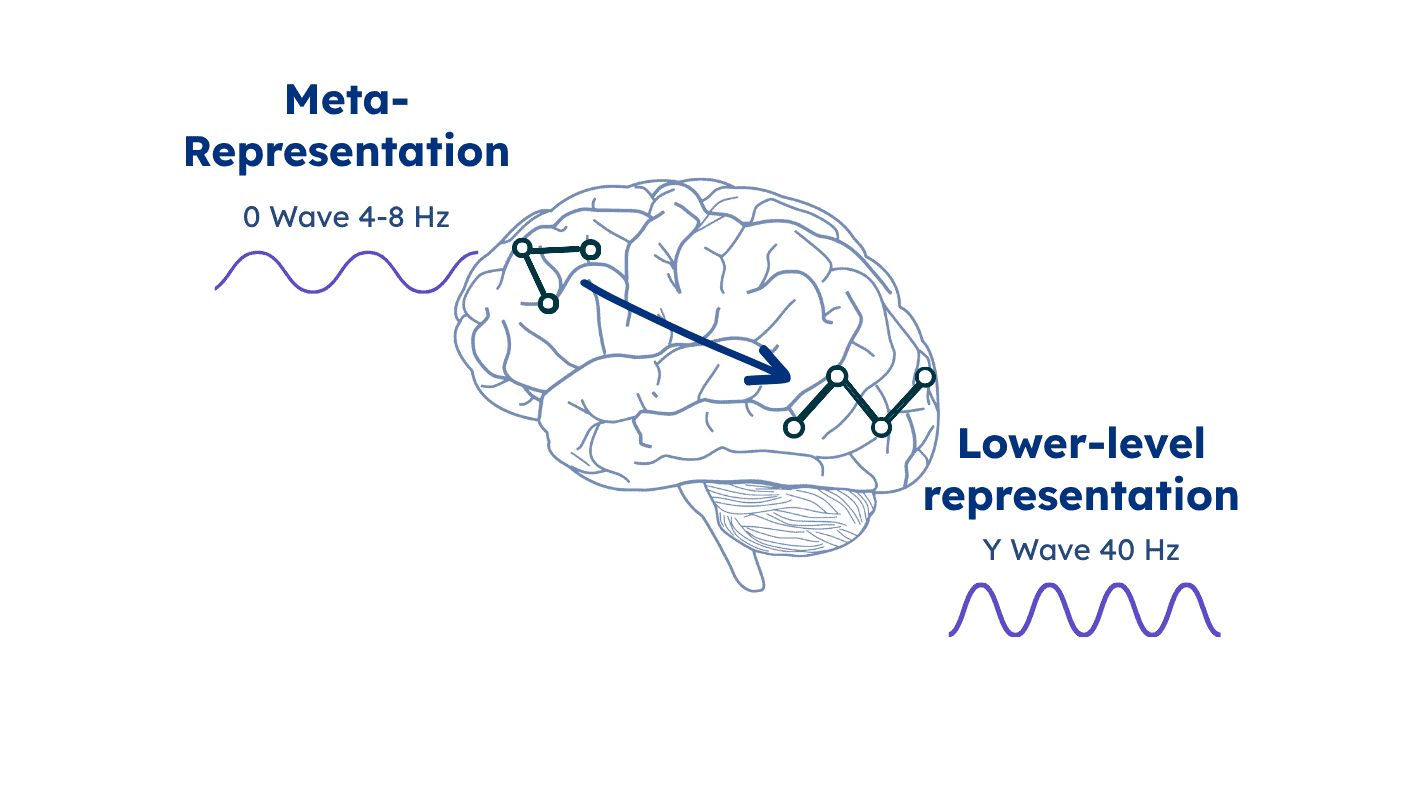

Essa figura ilustra de forma clara e simples como o nosso cérebro funciona, usando uma linguagem natural e fácil de entender: Nosso cérebro possui áreas conectadas entre si (redes neurais). O córtex pré-frontal, que fica na parte da frente da cabeça, perto da testa, cuida de tarefas que exigem mais raciocínio, como pensar logicamente ou planejar algo. Ele opera em um ritmo mais lento comparado a outras regiões do cérebro – é como se ele fosse o “chefe” que guia as demais partes em ações específicas, para ajudar a desenvolver um pensamento ou ideia. Enquanto ele se concentra no quadro geral, no plano amplo ou na estratégia, as outras áreas respondem a comandos mais simples e diretos.

Essas outras áreas também podem atuar de forma independente. Por exemplo, quando você reage imediatamente a uma situação de perigo, surpresa ou a um estímulo simples, como um beliscão, são elas que entram em ação, sem precisar de muito “pensamento”. Elas trabalham em um ritmo mais rápido, com ondas cerebrais ao redor de 40 Hz, o oposto da região do córtex pré-frontal, que lida com o raciocínio amplo e opera com ondas cerebrais de 4 a 8 Hz.

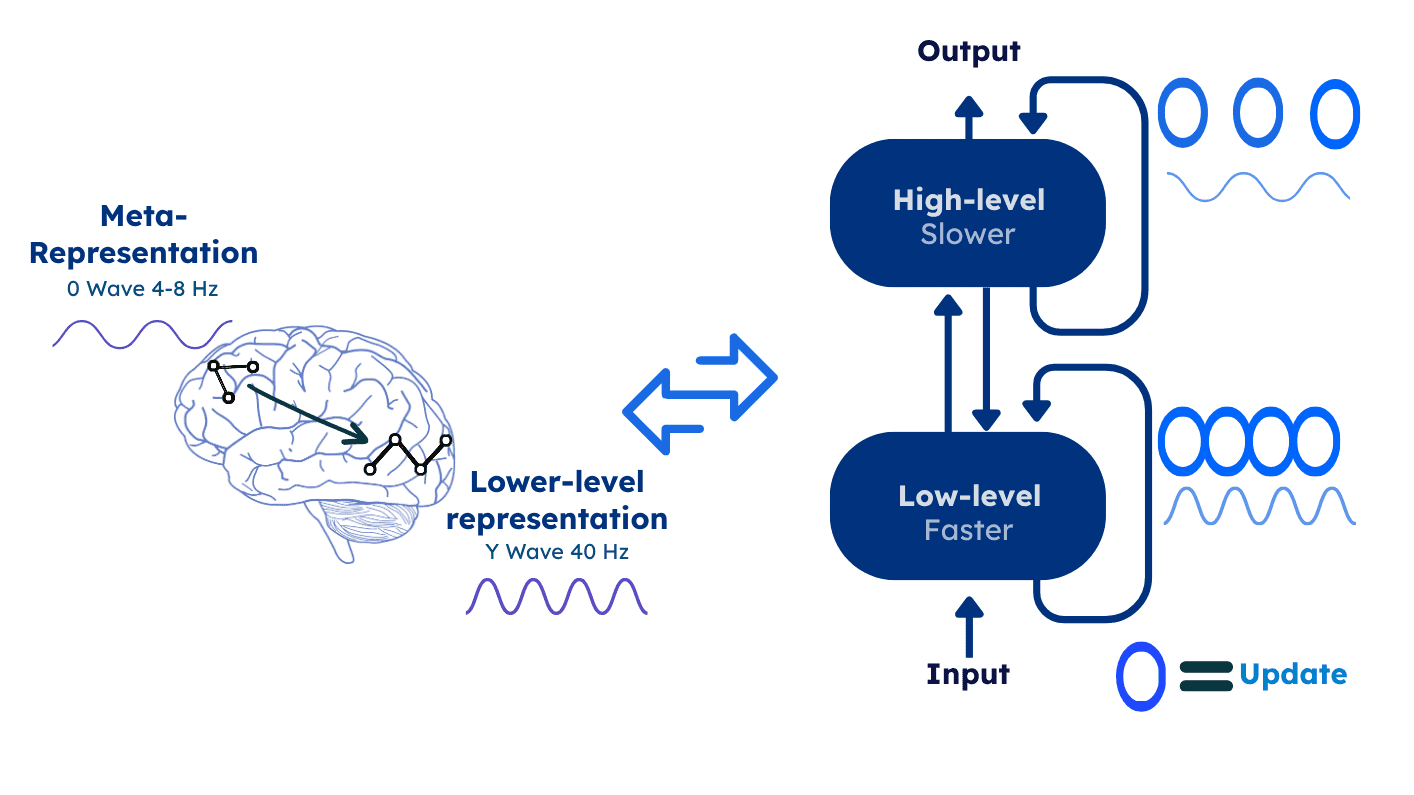

Quando surge a necessidade de desenvolver uma ideia, o córtex pré-frontal ativa essas outras áreas para buscar informações específicas. Elas ajudam a formar o raciocínio e a decisão sobre essa ideia. Isso acontece várias vezes, em um vai e vem, até que ele reúna dados suficientes para chegar a uma conclusão ou tomar uma atitude sobre o pensamento inicial e então é chegado o momento de parar essa atividade e seguir com a decisão, o plano, a resposta. Se fizermos um paralelo é exatamente assim que as empresas funcionam, ou seja, faz todo o sentido.

A Evolução Recente da IA e a Corrida por Modelos Melhores

A IA existe desde os anos 1950 e, de fato, evoluiu bastante desde então. Essa evolução veio da aplicação de modelos matemáticos já conhecidos, e hoje, graças à maior capacidade computacional disponível e aos modelos pré-treinados e de acesso público, estamos podendo participar de forma mais democrática dessa jornada. No entanto, quando falamos de ferramentas como ChatGPT, Gemini ou DeepSeek, a “corrida da IA” (semelhante à antiga corrida espacial para chegar à Lua) foca principalmente – ou quase totalmente – na descoberta de modelos que otimizam o tempo de treinamento e a quantidade de dados necessários. Em resumo, é sobre criar IAs mais eficientes e “inteligentes”.

A Analogia do Lego e os Modelos Matemáticos

Podemos comparar isso a uma mesa cheia de peças de Lego (representando esses modelos matemáticos clássicos), onde cada participante tem a chance de montar algo novo. No final, cada um constrói uma peça diferente (um modelo de IA único), mas todos usam as mesmas peças básicas disponíveis (modelos matemáticos antigos e conhecidos a muito tempo). É assim que explicamos por que esses modelos variam em resultados, consumo de tempo e energia – tudo depende de como as peças são combinadas.

Assim nasceu a pouco menos de 6 meses atrás, esse novo modelo, o HRM, que economiza tempo de treino, energia, quantidade de informação necessária para ser treinada e entrega um resultado muito superior aos modelos de IA já existentes e advinha como: Engenharia reversa do nosso cérebro levou esses cientistas a desenvolver um modelo de IA com funcionamento exatamente igual ao nosso cérebro como explicado acima, sem adivinhações e sim com raciocínios efetivos.

Modelo HRM

O HRM (Hierarchical Reasoning Model), um avanço que espelha mais fielmente o funcionamento do cérebro humano. Inspirado no processamento hierárquico e multiescala do cérebro, o HRM divide o raciocínio em dois módulos interdependentes: um de alto nível (H), para planejamento abstrato e lento; e um de baixo nível (L), para cálculos rápidos e detalhados. Isso permite profundidade computacional sem os gargalos tradicionais.

Cross Frequency Coupling x HRM

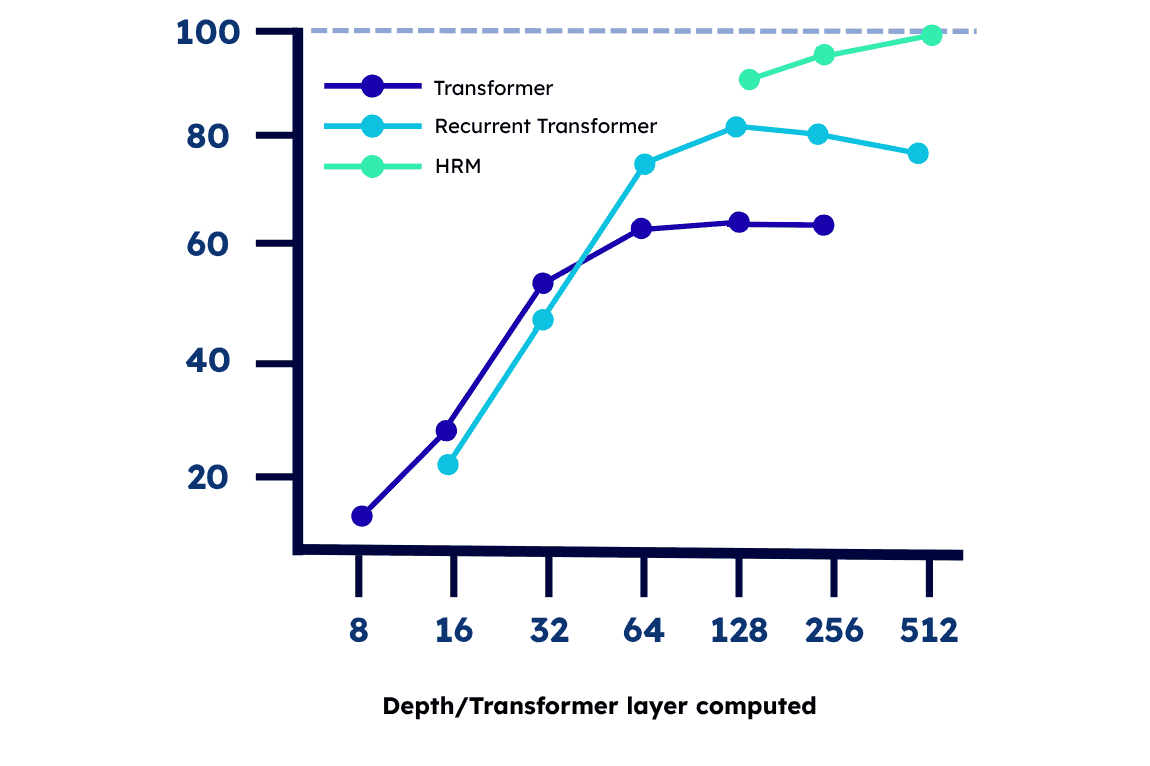

Os ganhos são impressionantes em comparação ao LLM:

Eficiência em parâmetros: Enquanto LLMs demandam bilhões, o HRM usa apenas 27 milhões.

Treinamento mínimo: Basta 1.000 exemplos, sem pré-treinamento ou dados de Chain-of-Thought (CoT).

Desempenho superior: Supera LLMs em tarefas complexas como Sudoku extremo, labirintos grandes e o ARC-AGI, benchmark de inteligência geral.

Linguagem vs. Espaço Latente

Em essência, LLMs usam a linguagem como base para raciocínio (podemos até dizer que seria um resultado um pouco “artificial”), gerando tokens sequenciais. Já o HRM opera em um “espaço latente”, como o cérebro: prioriza conexões neurais e representações internas, com a linguagem como ferramenta secundária. O cérebro organiza computação em escalas de tempo variadas, com loops recorrentes que refinam ideias sem custos proibitivos – e o HRM captura isso, alcançando coerência global com eficiência.

Com mais de 35 anos empreendendo com tecnologia, jamais imaginei que a biologia seria chave para o desenvolvimento da tecnologia, em especial a IA. É inspirador ver como essa “obra-prima” de DEUS guia avanços artificiais. O que vocês acham? Estamos no limiar de uma IA verdadeiramente geral?